VALMENTO

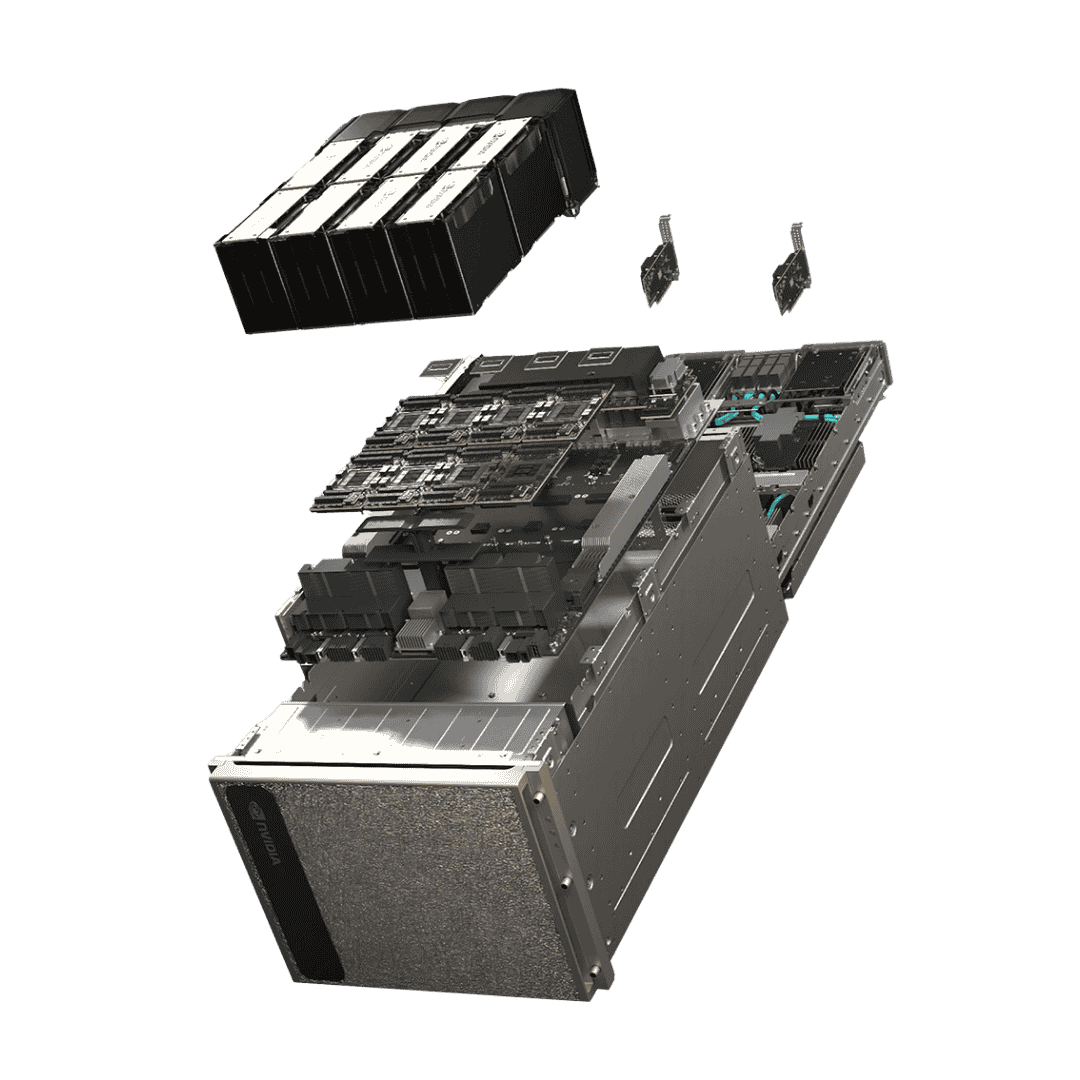

NVIDIA DGX H200 AI Server – Die ultimative Rechenmaschine für künstliche Intelligenz

NVIDIA DGX H200 AI Server – Die ultimative Rechenmaschine für künstliche Intelligenz

Couldn't load pickup availability

Maximale Leistung & Skalierbarkeit

Mit einer Gesamt-GPU-Speichergröße von 1.128 GB und vier NVIDIA NVSwitch-Einheiten bietet der DGX H200 außergewöhnliche Datenbandbreite und Performance. Die Dual Intel® Xeon® Platinum 8480C Prozessoren mit insgesamt 112 Kernen sorgen für kompromisslose Rechenpower bei anspruchsvollsten KI-Workloads.

Perfekt für Training & Inferenz von KI-Modellen

Der DGX H200 wurde für die nächste Generation von KI-Anwendungen entwickelt – von der Schulung großer Sprachmodelle bis hin zu komplexen Simulationen. Mit einer Netzwerkgeschwindigkeit von bis zu 400 Gb/s (InfiniBand & Ethernet) ermöglicht das System eine hochskalierbare Cluster-Architektur ohne Engpässe.

Technische Daten

- GPU: 8 × NVIDIA H200 Tensor Core GPUs (1.128 GB Gesamtspeicher)

- Leistung: 32 PetaFLOPS FP8

- CPU: Dual Intel® Xeon® Platinum 8480C – 112 Kerne, bis zu 3,8 GHz

- Arbeitsspeicher: 2 TB System-RAM

- Netzwerk: 4 × OSFP-Ports, bis zu 400 Gb/s InfiniBand / Ethernet

- Speicher: 2 × 1,9 TB NVMe M.2 (OS) + 8 × 3,84 TB NVMe U.2 (Intern)

- Leistungsaufnahme: ~10,2 kW (maximal)

- Software: NVIDIA AI Enterprise, Base Command, DGX OS / Ubuntu / RHEL / Rocky

- Abmessungen: 897 × 482 × 356 mm (L × B × H)

- Gewicht: 130,45 kg

Enterprise-KI-Infrastruktur der nächsten Generation

Dank der NVIDIA AI Enterprise Software Suite und dem Base Command Manager wird das Management, Monitoring und die Skalierung von KI-Clustern effizient und übersichtlich. Das sorgt für maximale Stabilität, Energieeffizienz und Performance im professionellen Dauereinsatz.

Warum der NVIDIA DGX H200?

- Branchenführende KI-Leistung dank Hopper-Architektur

- Maximale Effizienz und Zuverlässigkeit auf Enterprise-Niveau

- Voll kompatibel mit Cloud- und On-Premise-AI-Systemen

- Ideal für LLM-Training, Simulationen und Rechenzentren

- Unterstützt durch das globale NVIDIA Enterprise-Ökosystem

Perfekt geeignet für: KI-Labore, Cloud-Rechenzentren, Universitäten, Unternehmensforschung und Hochleistungssimulationen.

Hinweis: Der NVIDIA DGX H200 ist für den professionellen Einsatz in Hochleistungsrechenzentren konzipiert. Eine fachgerechte Installation und leistungsstarke Kühlinfrastruktur sind erforderlich.

Unboxing ansehen: YouTube Video – NVIDIA DGX H200 Unboxing & Übersicht

Share